爬虫代理池是什么?这篇帮你快速搞懂它!

- 网站运营杂谈

- 2025-01-09

- 194

说到爬虫,这玩意儿真是让人又爱又恨。有时候想搞点数据,又怕被人家网站给封,我就琢磨着搭个代理池。今儿我就来跟大家伙儿聊聊我是咋整的这个代理池。我是两眼一抹黑,啥也不懂。...

说到爬虫,这玩意儿真是让人又爱又恨。有时候想搞点数据,又怕被人家网站给封,我就琢磨着搭个代理池。今儿我就来跟大家伙儿聊聊我是咋整的这个代理池。

我是两眼一抹黑,啥也不懂。就想着,不就是找一堆代理IP,然后用的时候换着用嘛说干就干,我就去网上找那些免费的代理IP网站,别说,还真不少。我吭哧吭哧地写个爬虫,把这些网站上的代理IP都给爬下来。

爬完之后,我就得验证一下这些IP能不能用。这可咋整?我就写个小程序,用每个代理IP去访问一个网站,看看能不能访问成功,访问速度咋样。这一步还挺关键,毕竟咱不能用那些慢的要死或者根本连不上的代理。

等我把能用的代理IP都挑出来之后,我就得把它们存起来。我一开始想的是,要不就存文本文件里?后来一想,这不行,以后用的时候还得读文件,多麻烦。于是我就用个数据库,把这些代理IP都存进去。这下,用的时候直接从数据库里拿,方便多。

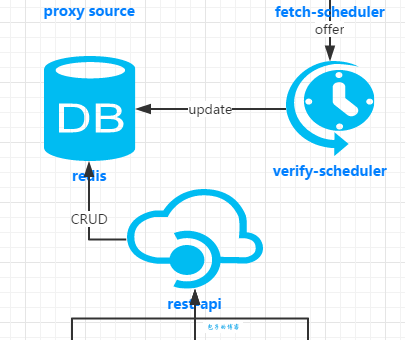

我得定时去更新这个代理池。为啥?因为这些免费的代理IP,很多都活不长,说不定啥时候就挂。我就写个定时任务,每隔一段时间就去跑一遍前面的流程:爬取、验证、存储。这样,就能保证我的代理池里,总有一批新鲜可用的代理。

然后,我就开始琢磨,咋能让这个代理池更好用?我想个招,给每个代理IP打个分。咋打分?就根据它访问网站的速度和稳定性来呗。访问速度快的,稳定性好的,分数就高;反之,分数就低。这样,我在用代理的时候,就优先选那些分数高的,效率杠杠的。

为让这个代理池用起来更方便,我还弄个接口。这样,别的程序或者服务,就能通过这个接口来获取代理IP。这一步,对于想搞分布式爬虫的哥们儿来说,简直就是福音。每个爬虫都能从这个接口获取代理IP,再也不怕被封。

总结

这个代理池我是这几步搞定的,爬取数据、验证代理、存储代理、定时更新、打分排序。现在用起来,那叫一个顺手。虽说这过程也踩不少坑,但总算是给弄出来。希望我这番捣鼓,能给想搞代理池的朋友们提供一些小灵感。